Algumas semanas são bastante tranquilas nas notícias de IA, mas em algumas semanas, controlar os eventos da semana é como tentar conter a maré. Esta semana houve três lançamentos notáveis de Large Language Model (LLM): Google Gemini Pro 1.5 hit Disponível publicamente Com o nível gratuito, a OpenAI enviou um Nova versão GPT-4 Turbo e Mistral lançaram um novo LLM com licença aberta Composição 8x22B. Todos os três lançamentos ocorreram 24 horas após o lançamento de terça-feira.

O engenheiro de software e pesquisador independente de IA Simon Willison (que também escreveu sobre (o emocionante lançamento do LLM desta semana em seu próprio blog), resumiremos brevemente cada um dos três eventos principais em ordem aproximadamente cronológica e, em seguida, nos aprofundaremos em alguns eventos adicionais de IA esta semana.

Lançamento público do Gemini Pro 1.5

Terça-feira de manhã, horário do Pacífico, Google declarado Seu modelo Gemini 1.5 Pro (lançado pela primeira vez em fevereiro) está agora disponível em versão prévia pública por meio da API Gemini em mais de 180 países, exceto a Europa. É o LLM público mais poderoso do Google até agora e está disponível em um nível gratuito que permite até 50 solicitações por dia.

Suporta um ambiente de entrada de até 1 milhão de tokens. Como observa Willison Em seu blogO custo da API do Gemini 1.5 Pro de US$ 7/milhão de tokens de entrada e US$ 21/milhão de tokens de saída é ligeiramente inferior ao do GPT-4 Turbo (Preço US$ 10/milhão e US$ 30/milhão de saída) e Claude 3 Sonnet (Anthropics Mid-Tier LLM, Preço US$ 3/milhão e US$ 15/milhão de saída).

Notavelmente, o Gemini 1.5 Pro inclui processamento de entrada de áudio (fala) nativo que permite aos usuários fazer upload de prompts de áudio ou vídeo, uma nova API de arquivo para lidar com arquivos, a capacidade de adicionar instruções de sistema personalizadas (instruções do sistema) para orientar respostas de amostra e JSON. Metodologia para extração estruturada de dados.

Saída turbo GPT-4 “principalmente melhorada”

Um pouco depois do lançamento 1.5 Pro do Google na terça-feira, a OpenAI anunciou o lançamento de uma versão “significativamente melhorada” do GPT-4 Turbo (uma família de modelos lançada em novembro) chamada GPT-4-turbo-2024-04. -09.” Integra processamento de visão multimodal GPT-4 (reconhecimento do conteúdo das imagens) diretamente no modelo e foi inicialmente lançado apenas através de acesso API.

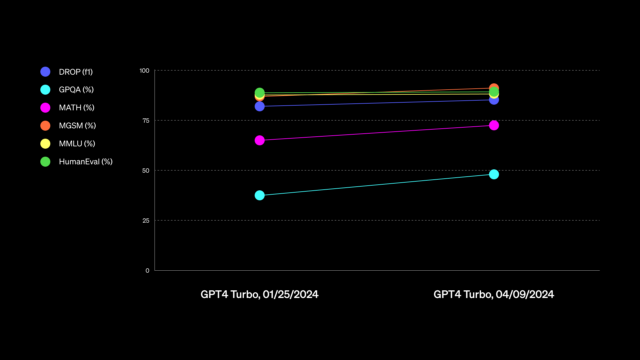

Na quinta-feira, a OpenAI anunciou que o novo modelo GPT-4 Turbo está disponível para usuários pagos do ChatGPT. O novo modelo da OpenAI “melhora as habilidades de escrita, matemática, raciocínio lógico e codificação” e compartilhou um gráfico Não é particularmente útil na avaliação de competências (que mais tarde Atualizada) empresa também Ele deu um exemplo A suposta melhoria é que o assistente de IA usará “linguagem mais direta, menos detalhada e mais coloquial” ao escrever com ChatGPT.

A imprecisão dos anúncios GPT-4 Turbo da OpenAI pegou alguns desprevenidos confusão e análises on-line. Em X, Willison escreveu, “Qual é o primeiro provedor de LLM a publicar notas de publicação verdadeiramente úteis?” De certa forma, este é novamente um caso de “vibração de IA”, que discutimos em nosso lamento sobre o mau estado dos benchmarks LLM durante a introdução do Clad 3. “Eu realmente não vejo nenhuma diferença definitiva na qualidade. [related to GPT-4 Turbo]”, Willison nos disse diretamente em uma entrevista.

A atualização estendeu a barreira de conhecimento do GPT-4 até abril de 2024, embora alguns relatem ter atingido esta Pesquisas furtivas na web Em segundo plano e outros nas redes sociais Problemas relatados Junto com confusões relacionadas à data.

O misterioso lançamento Mixtral 8x22B de Mistral

Na noite de terça-feira, a empresa francesa de IA Mistral lançou seu mais recente modelo licenciado abertamente, o Mixtral 8x22B. Tweetando um link de torrent Como feito nas versões anteriores, sem qualquer documentação ou comentário.

A nova saída Composite of Expertise (MoE) pesa um número maior de parâmetros do que seu antecessor, o modelo aberto mais eficiente. Composição 8x7B, cobrimos em dezembro. Há rumores de que é tão capaz quanto o GPT-4 (como, você pergunta? Vibrações). Mas ainda está para ser visto.

“Os níveis ainda estão rolando, mas a maior questão em aberto agora é quão bem o Mixtral 22x8B foi projetado”, disse Willison a Ars. “Se estiver na mesma classe de qualidade do GPT-4 e do Claude 3 Opus, finalmente teremos um modelo licenciado abertamente que não está por trás de um grande proprietário.”

O lançamento deixou Willison muito animado: “Se for realmente da classe GPT-4, isso é uma pena, porque você pode executá-lo em um laptop (muito mais caro). Acho que ele precisa de 128 GB de RAM do MacBook, o dobro do meu.”

O novo Mixtral ainda não alcançou sucesso na arena do chatbot, observou Willison, porque a Mistral ainda não lançou um modelo melhor para bate-papo. Ainda é um LLM de token bruto e de previsão do próximo. “Agora existe pelo menos uma versão voltada para a instrução social”, diz Willison.

Mudanças na tabela de classificação do Chatbot Arena

Benj Edwards

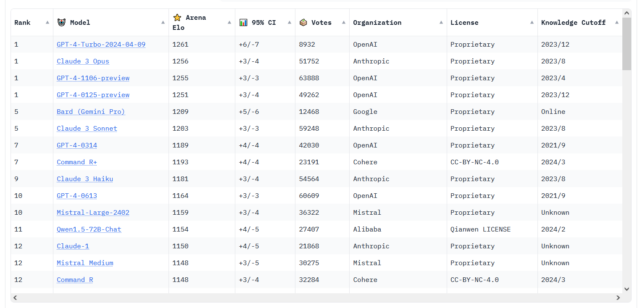

As notícias do LLM desta semana não tratam apenas de grandes nomes da área. Há rumores nas redes sociais sobre a crescente eficácia de modelos de código aberto como o Coheres. O comando é R+qual Alcançou a 6ª posição LMSYS Chatbot Arena Leaderboard – Classificação mais alta para modelo de peso aberto.

E para o desempenho do Chatbot Arena, a nova versão do GPT-4 Turbo se mostra competitiva com o Claude 3 Opus. Os dois ainda estão estatisticamente equilibrados, mas recentemente o GPT-4 Turbo Ele puxou para frente em números. (Em março, informamos que o Claud 3 havia ultrapassado pela primeira vez o GPT-4 Turbo, marcando a primeira vez que outro modelo de IA ultrapassou um membro do modelo da família GPT-4 na tabela de classificação.)

Sobre esta competição acirrada entre LLMs – que a maior parte do mundo das máscaras não conhece e nunca conhecerá – Wilson disse a Ars: “Os últimos meses foram um turbilhão – finalmente temos não apenas um, mas vários modelos que competem com o GBT.-4.” Veremos se o suposto lançamento do GPT-5 da OpenAI ainda este ano restaura a liderança tecnológica da empresa, que antes parecia intransponível. Mas, por enquanto, diz Willison, “OpenAI não é mais o líder indiscutível em LLMs”.